ChatGPT,引爆了人工智能硬件需求

来源:DELL 发布时间:2023-03-20 16:03:04 阅读量:566

万众瞩目的第四代大型语言模型(LLM)GPT-4(Generative Pre-trained Transformer 4)正式亮相了。过去几个月来,我们已经见识到其前辈GPT-3.5的威力——基于该模型开发的聊天机器人工具ChatGPT持续霸榜各大新闻头条,引爆了各行各业对人工智能的兴趣。

升级版GPT-4将更进一步,作为多模态人工智能,它能将文本相应地翻译成图像、音乐和视频,而且基本上“适用于所有语言”,可以“用德语提问,用意大利语得到答案。”

从ChatGPT看AI算力需求

然而,ChatGPT虽好,烧钱也不少。

据OpenAI创始人Sam Altman透露,ChatGPT平均每次回复会花掉“个位数美分”,访问的人越多消耗的带宽和服务器成本就越高,结合其已破亿的月活跃用户,OpenAI运行ChatGPT每个月至少要烧掉数百万美元。

这只是消费端的成本,后端训练花销更令人咋舌。

相关数据显示,ChatGPT的总算力消耗约为3640PF-days,即按照每秒计算一千万亿次的速度,3640天才能计算完,需要7-8个投资规模30亿、算力500P的数据中心才能支撑运行。

考虑到大模型GPT的参数量,ChatGPT吃算力就不奇怪了,从GPT到GPT-2再到GPT-3(当前开放的版本为GPT-3.5),GPT已经经历了三次迭代,参数量从1.17亿增加到1750亿!

而根据OpenAI之前的研究,AI计算量每3.4个月就要翻一番,远超摩尔定律(翻倍周期约为18个月)。随着数以万计参数的大型语言模型不断发展,硬件可能成为人工智能更进一步的瓶颈,因此,在以生成式AI为代表的人工智能时代,算力是下一步发展重点。

AI市场,硬件增长最快

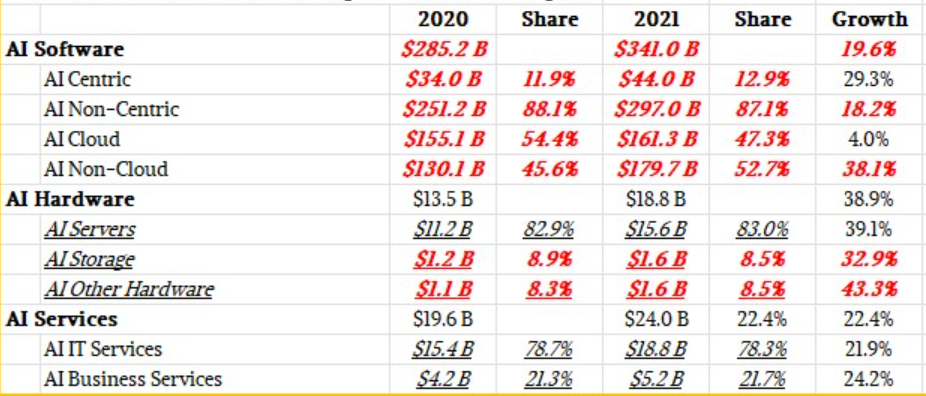

全球人工智能市场的支出表现也印证了算力的重要性。

根据IDC的《全球半年度人工智能跟踪报告》,“人工智能硬件是人工智能市场中规模最小(188 亿美元)但增长最快的部分 (同比增长 38.9%)。”人工智能硬件的增长是由构建专门的人工智能系统所推动的,该系统能够满足人工智能模型和数据集不断增长的计算和存储需求。

在硬件上市场,AI服务器和AI存储分别增长了39.1%和32.9%,但服务器采购额增加更为显著,达到了156亿美元。

根据来源于IDC的数据整理(如下图),存储和网络加起来仅占 AI 硬件成本的17%,剩下的83%都是服务器成本——可见,用户将可以花在计算上的每一分钱都用在了计算上。

图源:nextplatform

IDC预测,全球AI市场规模将在2025年增长至2218.7亿美元,2022至2026年期间,以 AI 为中心的总体支出的复合年增长率为26.5%,是整个IT市场增长率的四倍多。

新一代PowerEdge

专为AI而生

不少行业和组织都发现了人工智能技术的好处,因为日益强大的人工智能解决方案正在实现更优的决策和更高的生产率,帮助企业快速实现数字转型。在投入AI热潮之前,选择恰当的算力基础设施是必要的。

为了帮助组织应对严苛工作负载、实现 AI性能的跨越式发展,戴尔在国际超算大会SC22上推出了专为增强高级工作负载而打造PowerEdge XE9680系统(将于2023年上半年上市)。

Dell PowerEdge XE9680是一款6U服务器,基于NVIDIA HGX H100架构构建,配备八个NVIDIA H100 Tensor Core GPU,以满足对大规模Al和HPC工作流不断增长的需求,包括用于通信、化学和生物学的大型语言模型,以及航空航天、农业、气候、能源和制造业等行业的模拟和研究。

值得注意的是,2022年9月,NVIDIA H100首次亮相MLPerf AI训练基准测试即刷新了世界纪录,是世界上最先进的GPU。它包含800亿个晶体管,并具有在数据中心规模加速 AI、HPC、内存带宽和互连方面的重大进步。

H100可帮助组织处理和改进大型数据集并加速其AI驱动的业务,它具有专用的Transformer Engine和第四代NVIDIA NVLink互连,可加速百亿亿级工作负载。基于 NVIDIA HGX H100 平台构建的PowerEdge XE9680专为实现最佳AI性能而构建,能够帮助实现运营和基础架构的现代化以推动AI计划实施。

过去几十年来,戴尔NVIDIA一直通力合作为客户提供更好的服务。无论是建造更高效的火箭,还是研究分子行为,凝结了戴尔和NVIDIA技术成果的PowerEdge XE9680都能提供大规模AI和HPC工作负载所需的计算能力和效率,加速洞察。