NVIDIA 支撑自动驾驶车端云端同步迈入高算力大模型时代

来源:NVIDIA英伟达企业解决方案 发布时间:2023-03-23 16:58:30 阅读量:646

我国汽车产业发展迅速,汽车智能化大势所趋,自动驾驶所需的算力需求高速增长。为了加速自动驾驶生态发展,阿里云自动驾驶加速器与行业领先的主机厂、投资机构携手,结合自身技术、产品、业务资源,为自动驾驶创新企业提供多项支持。

3 月 10-11 日,NVIDIA 开发与技术部门亚太区总经理李曦鹏应邀出席阿里云自动驾驶加速器第一次线下集结活动并发表主题演讲《NVIDIA 支撑自动驾驶车端云端同步迈入高算力大模型时代》,演讲分享了自动驾驶领域 AI 的研发趋势和解决方案。

NVIDIA 开发与技术部门亚太区总经理李曦鹏

图片来源:阿里云自动驾驶加速器

以下为演讲内容:

自动驾驶需要通过大量的传感器获取环境信息,然后对这些数据进行处理和分析,而加速计算可以提供更快的数据处理速度和更高的精度。加速计算不仅对自动驾驶行业十分关键,也在数据处理、互联网和医疗等领域扮演着重要的角色,促进了这些行业的发展。

车端算力对于加速汽车智能化非常重要。作为自动驾驶链条的基础,车上的大算力芯片和解决方案是必不可少的。NVIDIA DRIVE 平台是全球最常用的自动驾驶平台之一,提供各种芯片和解决方案,包括车端、数据中心和仿真解决方案。

安全是开发自动驾驶的第一要务,更大的算力可以提高安全性。NVIDIA 在 2022 年秋季 GTC 宣布的 NVIDIA DRIVE Thor SoC 车规级系统芯片,可实现最高 2000 TOPS AI 算力以及 2000 TFLOPS 浮点算力,可以在单个计算平台整合全车的智驾和座舱功能,为未来的算法和应用发展预留足够空间。

应用和算力需要相互匹配,并且算力的发展需要一定的超前性以留给算法和应用发展足够的空间。近年来,BEV 和 Transformer 在深度学习领域取得了出色的效果,并带来了很大的效率提升。但同时也对计算量提出了更高的要求,因此出现了一些革命性的技术。

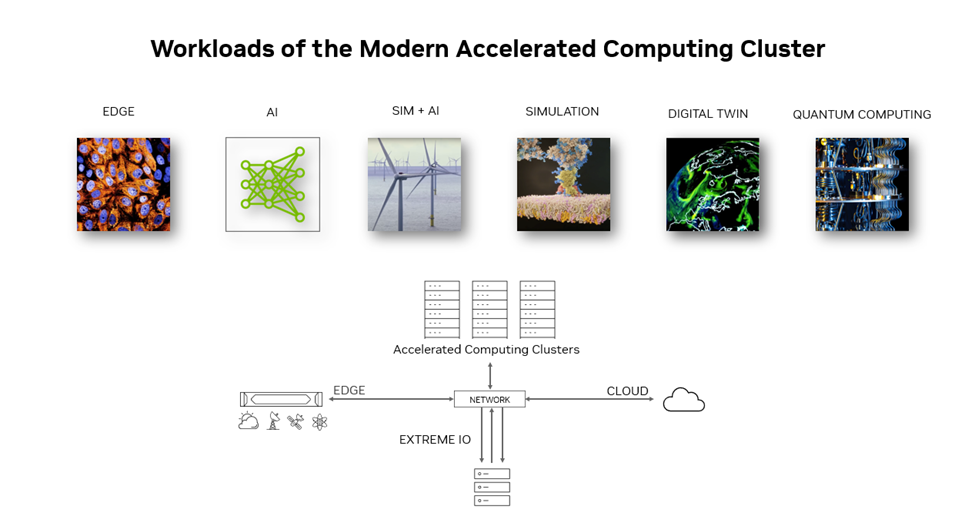

例如 Transformer Engine 和专门做 Transformer block 计算的技术等。除了 BEV 和 Transformer,NVIDIA 也针对各种其它模型,与云服务合作伙伴在云端进行训练和预测加速。对于现代加速的集群,其运行应用类别非常多,包括仿真、AI、scientific AI、数字孪生、量子计算等等,而这些应用都是典型的加速计算集群的应用。

当前,硬件性能提升放缓,每年只有 1.1 倍左右,五年期望的 10 倍提升实际只有 2 倍,十年期望的100倍提升只有 4 倍。此时,如果使用加速计算,每年保持 1.6 倍的提速,将为工作负载提供充足算力,成为应对性能瓶颈的重要解决方案。同时,也需要注意到成本问题,包括单个晶体管价格逐年增加、能源消耗、机房建设、供电等问题,因此需要更多的加速计算来降低成本和提高效率。

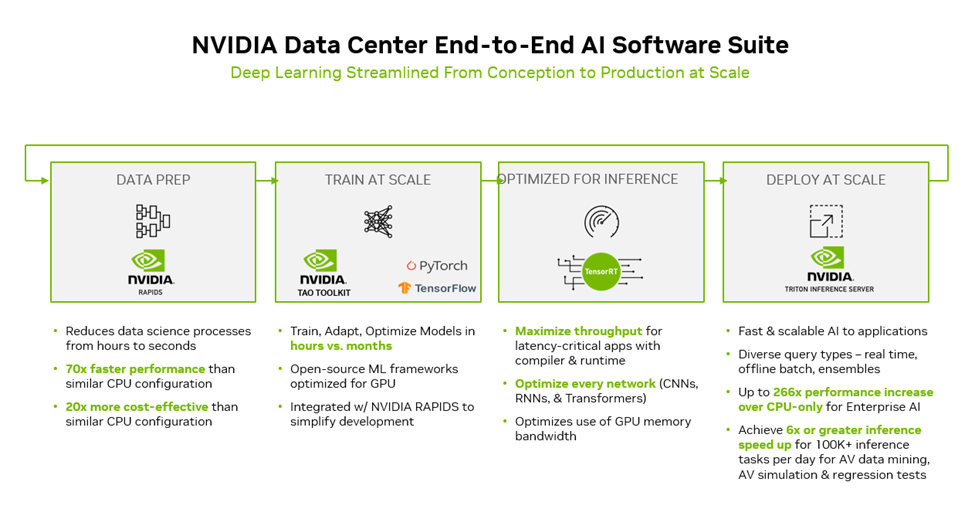

在自动驾驶领域,NVIDIA 能够提供丰富的工具和解决方案,帮助用户完成AI模型端到端的流程。对于数据预处理,NVIDIA 可以提供结构化和非结构化数据的处理工具,还可以进行图像处理,确保训练和预测的一致性。在训练方面,NVIDIA 可以提供不同的框架,同时也会关注模型的推理。在云端部署时,NVIDIA 提供大规模部署的工具。

NVIDIA 相信未来 10 年内,所有计算任务都将被加速,而 NVIDIA 已经为此做好了准备。加速计算的特点和意义在于,可以提高工作效率、降低成本、提升用户体验,同时也推动产业信息化融合的发展。这些特点和意义决定了 NVIDIA 的工作方式,即与客户和合作伙伴深度合作,根据客户需求设计出最适合的解决方案,共同进步。

加速计算的特点总结如下:

性能数量级上的提升:加速计算可以使模型性能有数十倍甚至上百倍的提升。

应用特异性:上层应用需要根据具体业务场景进行优化,没有一劳永逸的方法。

找出瓶颈:需要从应用自上而下寻找性能瓶颈,然后加速这些瓶颈,以达到整体性能的提升。

端到端的优化:AI 加速器算法的核心是优化,端到端的优化需要软件协同设计,需要业务、算法、工程人员和优化工程师共同配合。

自动驾驶软件产品研发特点如下三点:

第一,自动驾驶的端到端开发需要加速数据模型的流转,并让数据信息充分利用。例如在车端采集数据,需要对这些数据进行高效的利用,在云端进行自动打标或者模型训练、数据推理等过程,让数据从采集到被利用整个过程尽可能快。

第二,云端的训练、预测,车端的验证和部署需要保持模型和数据的对齐。不同的训练框架、预处理库和数据处理方式会导致模型和数据不对齐,因此需要将整个过程自动化起来并做到统一管理。

第三,如果车端和云端的算力出现问题时,需要设计更多创新性的大模型来解决实际的问题。

在云上,自动驾驶应用需要处理大量数据的采集、管理和筛选,数据管理包括人工和自动打标,还需进行模型训练和 REPLAY 验证。如果采集车数量够多,数据采集的长尾效应可以减少单辆车的数据量,但考虑到量产车的数量,数据处理必须更智能、高效。这已然成为自动驾驶企业的共识,而 NVIDIA 也将与云服务合作伙伴,结合在其他行业卓有成效的经验和成果,帮助企业落地相关能力。

总的来说,AI 加速计算可以大幅提升自动驾驶应用的性能,但对于不同的应用场景需要采用特定的方法进行优化。例如在视觉计算领域,Swin-transformer 模型在自驾行业有很好的应用场景,并且训练吞吐可以提高 2.3 倍,从而降低训练时间,提高模型验证和上线速度。

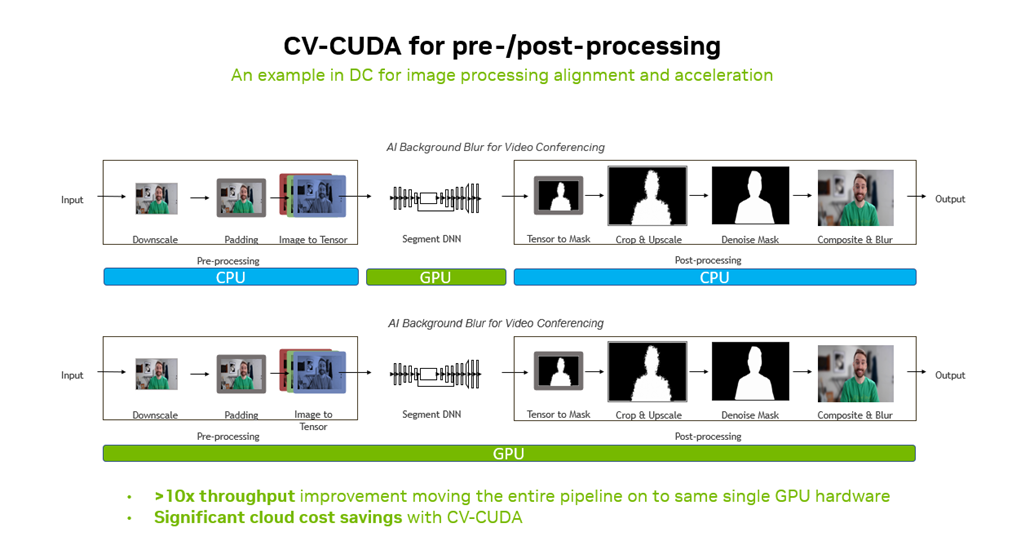

另外,CV-CUDA 开源库是一个通用的高性能图像处理加速库,适用于不同行业的 AI 成像前后处理,目前已经被短视频行业、自动驾驶行业和地图行业等多个领域广泛采用。仅就前处理而言,就可以减少训练和预测中调试工作量,提升模型对齐效果,提升工作效率。

加速计算需要软硬协同设计,仅依靠单一优化手段,很难达到效果,需要尽可能自上而下得去加速更多环节。AI 的核心是加速,而加速的核心是优化,这需要算法和优化工程师配合完成。

在自动驾驶领域,NVIDIA 将与云服务合作伙伴,依托其他领域的成功经验和成果,为车企和自动驾驶企业,提供端到端的全栈式 AI 加速计算解决方案。

我国汽车产业发展迅速,汽车智能化大势所趋,自动驾驶所需的算力需求高速增长。为了加速自动驾驶生态发展,阿里云自动驾驶加速器与行业领先的主机厂、投资机构携手,结合自身技术、产品、业务资源,为自动驾驶创新企业提供多项支持。

3 月 10-11 日,NVIDIA 开发与技术部门亚太区总经理李曦鹏应邀出席阿里云自动驾驶加速器第一次线下集结活动并发表主题演讲《NVIDIA 支撑自动驾驶车端云端同步迈入高算力大模型时代》,演讲分享了自动驾驶领域 AI 的研发趋势和解决方案。

NVIDIA 开发与技术部门亚太区总经理李曦鹏

图片来源:阿里云自动驾驶加速器

以下为演讲内容:

自动驾驶需要通过大量的传感器获取环境信息,然后对这些数据进行处理和分析,而加速计算可以提供更快的数据处理速度和更高的精度。加速计算不仅对自动驾驶行业十分关键,也在数据处理、互联网和医疗等领域扮演着重要的角色,促进了这些行业的发展。

车端算力对于加速汽车智能化非常重要。作为自动驾驶链条的基础,车上的大算力芯片和解决方案是必不可少的。NVIDIA DRIVE 平台是全球最常用的自动驾驶平台之一,提供各种芯片和解决方案,包括车端、数据中心和仿真解决方案。

安全是开发自动驾驶的第一要务,更大的算力可以提高安全性。NVIDIA 在 2022 年秋季 GTC 宣布的 NVIDIA DRIVE Thor SoC 车规级系统芯片,可实现最高 2000 TOPS AI 算力以及 2000 TFLOPS 浮点算力,可以在单个计算平台整合全车的智驾和座舱功能,为未来的算法和应用发展预留足够空间。

应用和算力需要相互匹配,并且算力的发展需要一定的超前性以留给算法和应用发展足够的空间。近年来,BEV 和 Transformer 在深度学习领域取得了出色的效果,并带来了很大的效率提升。但同时也对计算量提出了更高的要求,因此出现了一些革命性的技术。

例如 Transformer Engine 和专门做 Transformer block 计算的技术等。除了 BEV 和 Transformer,NVIDIA 也针对各种其它模型,与云服务合作伙伴在云端进行训练和预测加速。对于现代加速的集群,其运行应用类别非常多,包括仿真、AI、scientific AI、数字孪生、量子计算等等,而这些应用都是典型的加速计算集群的应用。

当前,硬件性能提升放缓,每年只有 1.1 倍左右,五年期望的 10 倍提升实际只有 2 倍,十年期望的100倍提升只有 4 倍。此时,如果使用加速计算,每年保持 1.6 倍的提速,将为工作负载提供充足算力,成为应对性能瓶颈的重要解决方案。同时,也需要注意到成本问题,包括单个晶体管价格逐年增加、能源消耗、机房建设、供电等问题,因此需要更多的加速计算来降低成本和提高效率。

在自动驾驶领域,NVIDIA 能够提供丰富的工具和解决方案,帮助用户完成AI模型端到端的流程。对于数据预处理,NVIDIA 可以提供结构化和非结构化数据的处理工具,还可以进行图像处理,确保训练和预测的一致性。在训练方面,NVIDIA 可以提供不同的框架,同时也会关注模型的推理。在云端部署时,NVIDIA 提供大规模部署的工具。

NVIDIA 相信未来 10 年内,所有计算任务都将被加速,而 NVIDIA 已经为此做好了准备。加速计算的特点和意义在于,可以提高工作效率、降低成本、提升用户体验,同时也推动产业信息化融合的发展。这些特点和意义决定了 NVIDIA 的工作方式,即与客户和合作伙伴深度合作,根据客户需求设计出最适合的解决方案,共同进步。

加速计算的特点总结如下:

性能数量级上的提升:加速计算可以使模型性能有数十倍甚至上百倍的提升。

应用特异性:上层应用需要根据具体业务场景进行优化,没有一劳永逸的方法。

找出瓶颈:需要从应用自上而下寻找性能瓶颈,然后加速这些瓶颈,以达到整体性能的提升。

端到端的优化:AI 加速器算法的核心是优化,端到端的优化需要软件协同设计,需要业务、算法、工程人员和优化工程师共同配合。

自动驾驶软件产品研发特点如下三点:

第一,自动驾驶的端到端开发需要加速数据模型的流转,并让数据信息充分利用。例如在车端采集数据,需要对这些数据进行高效的利用,在云端进行自动打标或者模型训练、数据推理等过程,让数据从采集到被利用整个过程尽可能快。

第二,云端的训练、预测,车端的验证和部署需要保持模型和数据的对齐。不同的训练框架、预处理库和数据处理方式会导致模型和数据不对齐,因此需要将整个过程自动化起来并做到统一管理。

第三,如果车端和云端的算力出现问题时,需要设计更多创新性的大模型来解决实际的问题。

在云上,自动驾驶应用需要处理大量数据的采集、管理和筛选,数据管理包括人工和自动打标,还需进行模型训练和 REPLAY 验证。如果采集车数量够多,数据采集的长尾效应可以减少单辆车的数据量,但考虑到量产车的数量,数据处理必须更智能、高效。这已然成为自动驾驶企业的共识,而 NVIDIA 也将与云服务合作伙伴,结合在其他行业卓有成效的经验和成果,帮助企业落地相关能力。

总的来说,AI 加速计算可以大幅提升自动驾驶应用的性能,但对于不同的应用场景需要采用特定的方法进行优化。例如在视觉计算领域,Swin-transformer 模型在自驾行业有很好的应用场景,并且训练吞吐可以提高 2.3 倍,从而降低训练时间,提高模型验证和上线速度。

另外,CV-CUDA 开源库是一个通用的高性能图像处理加速库,适用于不同行业的 AI 成像前后处理,目前已经被短视频行业、自动驾驶行业和地图行业等多个领域广泛采用。仅就前处理而言,就可以减少训练和预测中调试工作量,提升模型对齐效果,提升工作效率。

加速计算需要软硬协同设计,仅依靠单一优化手段,很难达到效果,需要尽可能自上而下得去加速更多环节。AI 的核心是加速,而加速的核心是优化,这需要算法和优化工程师配合完成。

在自动驾驶领域,NVIDIA 将与云服务合作伙伴,依托其他领域的成功经验和成果,为车企和自动驾驶企业,提供端到端的全栈式 AI 加速计算解决方案。