英伟达Quantum-2 Infiniband技术A&Q

来源:架构师技术联盟 发布时间:2023-07-26 14:51:03 阅读量:720

随着大数据和人工智能等技术的快速发展,高性能计算需求日益增长。英伟达Quantum-2 Infiniband平台应运而生,为用户提供高速、低延迟的数据传输和处理能力,实现卓越的分布式计算性能。

Quantum-2采用最新一代NVIDIA Mellanox HDR 200Gb/s Infiniband网络适配器,支持高速数据传输和低延迟计算。结合NVIDIA GPU,实现加速计算和分布式存储,提高计算效率和资源利用率。

此外,Quantum-2还支持多种先进技术,如NVIDIA RDMA、NVLink和Multi-host等,实现数据中心范围内的高效数据传输和资源共享。用户可根据实际需求,搭建高性能计算集群或分布式存储系统,为大数据分析、人工智能、科学计算等领域提供强大支持。

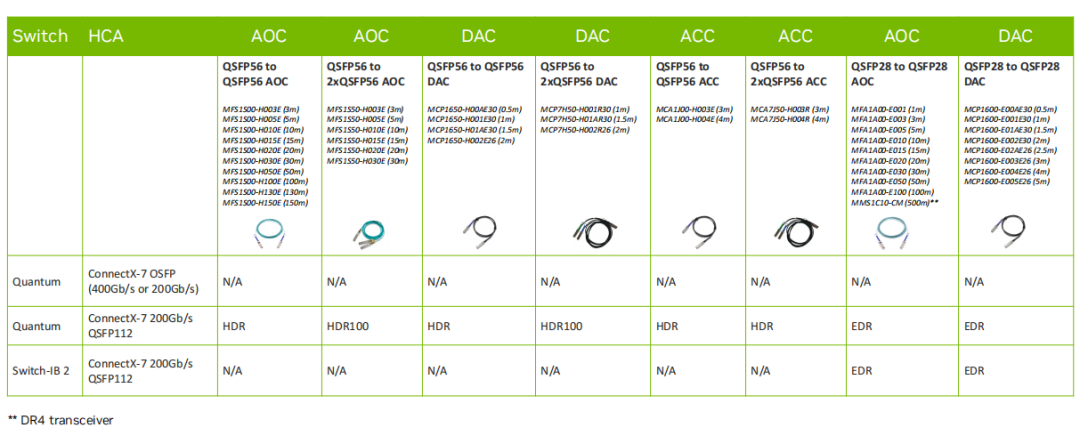

Q:CX7 NDR 200 QSFP112能否兼容HDR/EDR线缆?

A:可以

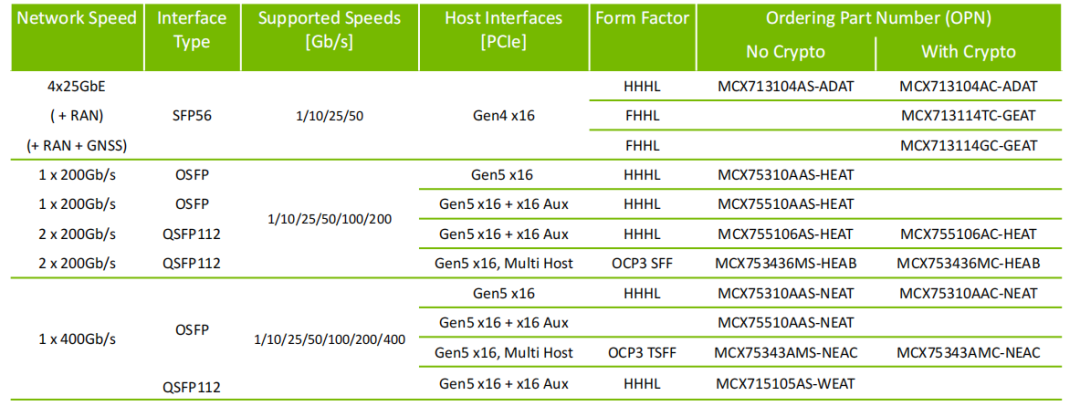

Q:CX7 NDR能否支持CR8模块?

A:CX7 NDR用Nvidia SR4多模或者DR4单模规格的模块,IB交换机侧使用SR8或者DR8模块。Q:CX7 Dual-port 400G能否bonding后达到800G,为啥200G bonding后能叠加达到400G?

A:目前CX7并没有双口400G配置,网络总性能由PCle带宽/网卡处理能力/网口物理带宽的瓶颈决定,PCle带宽上限为512G,网卡处理能力>400G,故双口200G bond可达到400G带宽。

Q:一分二线缆怎么连接

A:Al训练场景需配合NCCLSHARP通信环连接SU内不同节点的网卡。

Q:哪些卡是IB/ETH双模的,IB/ETH双模怎么切换

A:mlxconfig -d mlx5_x s LINK_TYPE_P1=1(Or 2)

Q: Superpod组网里,假如我每台服务器上配置4个NDR200的卡,那我能直接用一个一分四的线缆直接连接到同一个交换机上吗?还是说得用2根一分二的分别连不同的交换机?

A:不推荐,这种连接方式不符合SuperPoD组网规则,考虑到NCCL/SHARP性能,需要Leaf层交换机分别使用一分四线缆连接SU内不同服务器的NDR200端口,形成不同的通信环。

Q:Super Pod组网中,如果最后一个SU中,节点的数量不足32台,比如只有16台,那最后一个SU的Leaf交换机可以只用4台吗?这样会出现同一个节点的两个网卡接入到一个leaf交换机上,SHARP树会不会有问题?

A:可以但不推荐,NDR交换机可以支持64 SAT(SHARP Aggregation Tree)。

Q.NDR交换机上的同一个模块,一个口插NDR线缆,另一个口插NDR 200的一分二线缆吗?

A:可以,需要交换机侧做NDR口的端口分拆配置。

Q.有一个关于最新superpod组网的问题想咨询您一下,我看到最新的superpod组网白皮书是计算网络中单独配置2台IB交换机组UFM软件的网络,但是这样就导致了我集群会减少一台GPU节点。如果我不单独配置UFM交换机,只在管理节点部署UFM软件,在不占用计算网络的情况下通过另一套存储网络管理集群是否可以呢?

A:建议配置UFM设备(含软件),计算网内的管理节点部署UFM软件是可选方案,但该节点不应该承担GPU计算业务负载。 存储网络是单独组网的,是不同的网络平面,无法管理计算集群。

Q: UFM Enterprise,SDN, Telemetry, Cyber-Al有什么区别?是不是必须买UFM?

A:可使用OFED自带的opensm和命令脚本工具进行简单的管理和监控,但是不具备UFM友好的可视化界面,功能也少了很多。

Q:交换机的子网管理器,OFED的子网管理器,UFM,三个管理节点的数目是否有差异?客户部署时选择哪个比较合适?

A:管理交换机适合2K节点内的管理,UFM和OFED的openSM节点管理能力无限制,需要配合管理节点的CPU以及硬件处理能力。

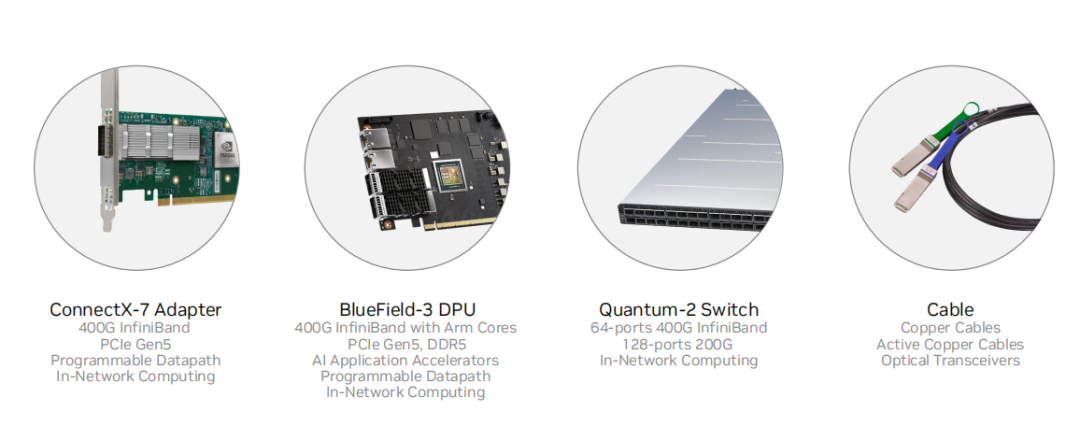

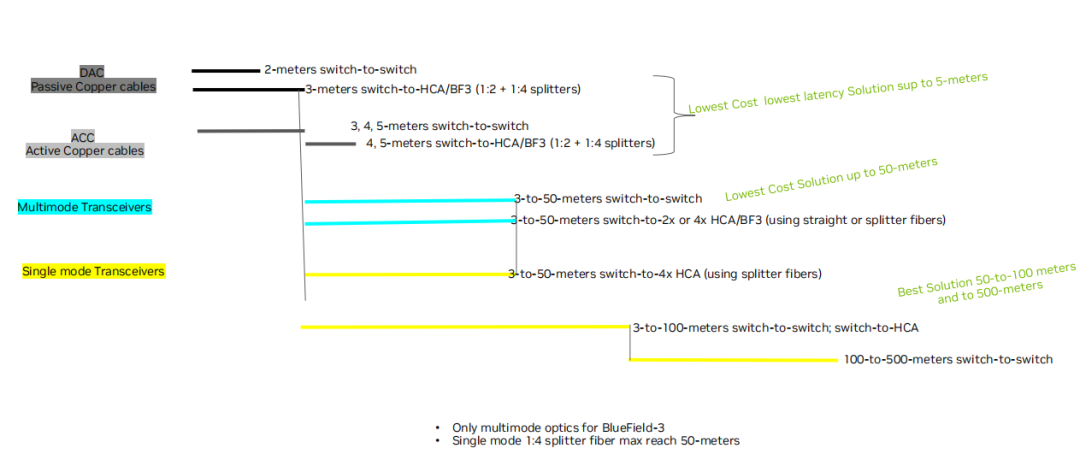

Q: DAC ACC AOC Transceiver的区别,每种的限制。

A:连接距离,布线的难易程度如下图。

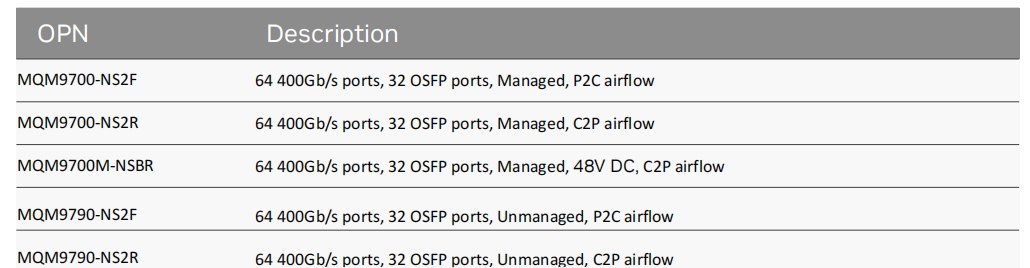

Q: 交换机 64 个 400Gb port, 为什么是 32 个 QSFP56 端口

A: 尺寸和功耗,2U 面板只能 32 cage;这是 OSPF 接口,支持两个 400G ports,NDR 交换机要把 cage 和 port 的概念区分清楚。

Q: 请问两端的模块不同,可以通过线缆链接起来打通数据吗?比如服务器这边是 OSFP,交换机是 QSFP112

A: IB 必须用我们的 module 和 cable,现在主要介绍 IB,IB 交换机只有是 OSFP;两侧的模块都要使用 NVIDIA 的推荐模块,可以支持

Q: UFM 可以用来监控 RoCE 网络吗

A: 不可以,只支持 IB

Q: UFM 跟有管理性 Switch 和非管性 switch, 功能性是否一樣

A: 一样

Q: IB 线缆在不影响传输带宽时延的前提下,最大支持多远的传输距离

A: 模块+cable,最远 500m,多模;DAC 铜缆 3m 以下,ACC 5m

Q: CX7 网卡开以太模式可以与其他家的 400G 支持 RDMA 的以太网交换机互联吗

A: 400G ethernet 互联可以,RDMA 是 RoCE,可以在这种情况下跑,性能没有保证;400G 以太网建议使用 BF3+Spectrum-4 组成的 Spectrum-X 平台

Q: NDR 兼容 HDR、EDR 的话,这种线缆和模块只有一体的吗?

A: 是的,没有分体的方案

Q: OSFP 网卡侧的模块应该是用的 flat 的吧?

A: 是的,网卡用 flat

Q: IB 卡开以太模式是不支持 RDMA 的吗?

A: 可以跑 RoCE,就是 RDMA over Ethernet,推荐用 Nvidia Spectrum-X solution

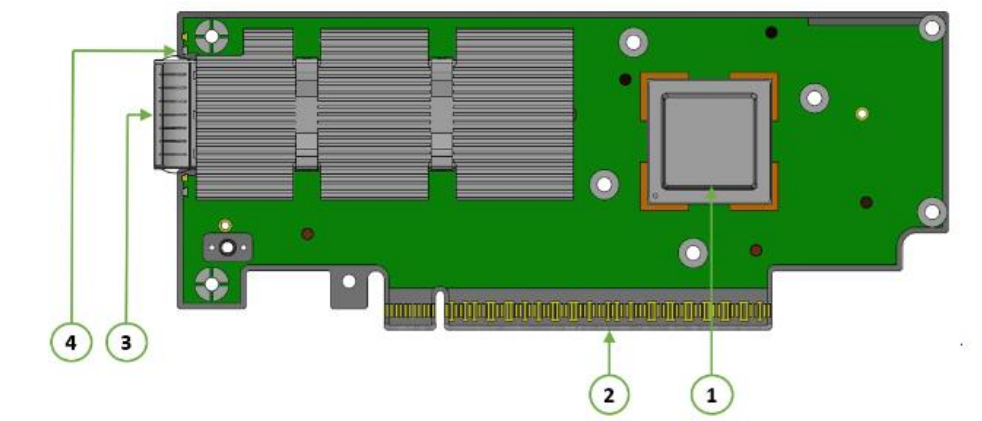

Q: BF3 现在量产了吗

A: 根据 OPN 不同,量产时间不同,具体跟负责 SA 联系,提供你需要的 OPN

Q: 为什么 NDR 的光缆是分开的,没有像 HDR 一样的那种 AOC 线缆呢

A: 混杂了单多模,风水冷,不同长度这些因素,AOC 一体的方案会非常复杂,部署也不灵活

Q: 请问 400G 的 IB 和 400G 的以太,除了光模块不一样,线缆是一样的吗

A: 光缆是相同的,注意是 APC 带 8 度斜角的类型

Q: CX7 网卡延时性能有具体要求么?在满内存,已绑核等最优调试环境下对于网络延时要求是?小于多少 us 算合适?

A: 这个跟测试机器的主频,配置都有关系,还跟测试用 perftest, mpi 工具都有关系,建议你联系负责 SA,给你提供具体支持

Q: OSFP 网卡侧的模块应该是用的 OSFP-flat 的吧?为啥会说用的是 OSFP-Riding Heatsink 的呢?

A: riding heatsink 指的是在 cage 上有个散热器

Q: 这个集群方案里 ufm 的部分在哪里呢?想了解下这部分的作用

A: UFM 单独跑在 server 上,可以当做一个 node,可以 HA 接两台. 但不建议跑 UFM 的node 同时跑计算业务

Q: 集群规模多大的时候,建议推荐 UFM 呢?

A: IB 网络都建议配置,UFM 不只是 opensm,还有其他非常强大的管理和接口功能

A: 只要客户有网管需求,建议都配置 UFM

Q: PCIe 5 是否只有 512G 嗎?PCIe4 是多少

A: Gen5 32G*16=512G, Gen 4 16G*16=256G

Q: IB 卡有单工或者双工说法吗