英伟达GPU龙头稳固,国内逐步追赶(详解)

来源:智能计算芯世界 发布时间:2023-09-14 11:06:53 阅读量:565

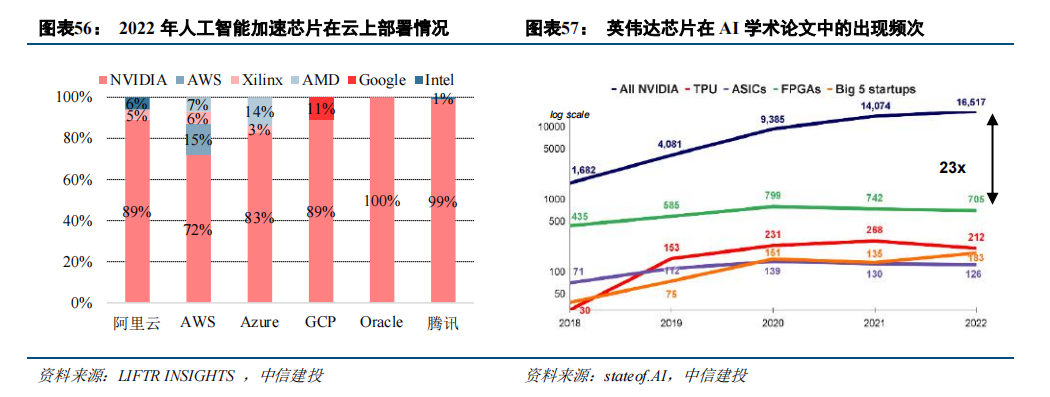

海外龙头厂商占据垄断地位,AI 加速芯片市场呈现“一超多强”态势。数据中心 CPU 市场上,英特尔份额有所下降但仍保持较大领先优势,AMD 持续抢占份额势头正盛。AI 加速芯片市场上,英伟达凭借硬件优势和软件生态一家独大,在训练、推理端均占据领先地位。根据 Liftr Insights 数据,2022 年数据中心 AI 加速市场中,英伟达份额达 82%,其余海外厂商如 AWS 和 Xilinx 分别占比 8%、4%,AMD、Intel、Google 均占比 2%。

国内厂商起步较晚正逐步发力,部分加速芯片领域已经涌现出一批破局企业,但目前多为初创企业规模较小,技术能力和生态建设仍不完备,在高端 AI 芯片领域与海外厂商仍存在较大差距。未来,随着美国持续加大对中国高端芯片的出口限制,AI 芯片国产化进程有望加快。

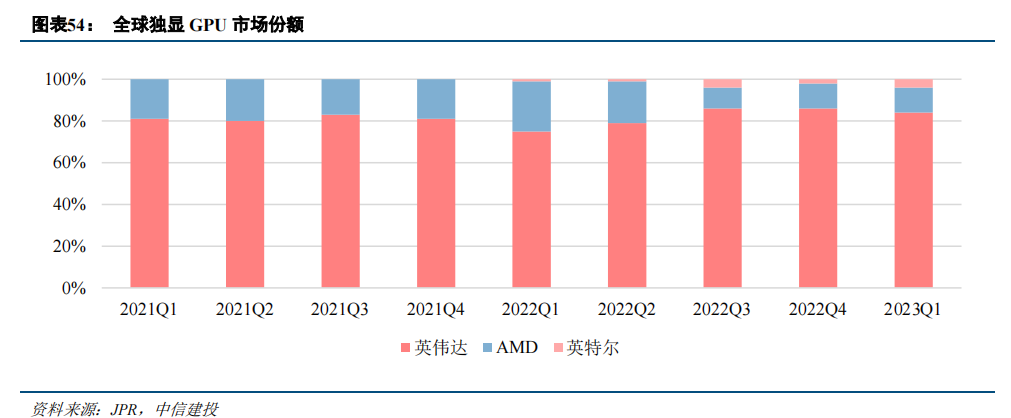

GPU 市场方面,海外龙头占据垄断地位,国产厂商加速追赶。当前英伟达、AMD、英特尔三巨头霸占全球 GPU 芯片市场的主导地位。集成 GPU 芯片一般在台式机和笔记本电脑中使用,性能和功耗较低,主要厂商包括英特尔和 AMD;独立显卡常用于服务器中,性能更高、功耗更大,主要厂商包括英伟达和 AMD。分应用场景来看,应用在人工智能、科学计算、视频编解码等场景的服务器 GPU 市场中,英伟达和 AMD 占据主要份额。根据 JPR,2023 年 Q1 英伟达的独立显卡(包括 AIB 合作伙伴显卡)的市场份额达 84%, AMD 和 Intel则分别占比 12%、4%。

图形渲染GPU:2006 年起,英伟达 GPU架构保持约每两年更新一次的节奏,各代际产品性能提升显著,生态构建完整,Geforce 系列产品市占率长期保持市场首位,最新代际 GeForce RTX 40 系列代表了目前显卡的性能巅峰,采用全新的 Ada Lovelace 架构,台积电 5nm 级别工艺,拥有 760 亿晶体管和 18000 个 CUDA 核心,与 Ampere 相比架构核心数量增加约 70%,能耗比提升近两倍,可驱动 DLSS 3.0 技术。性能远超上代产品。AMD 独立 GPU 在 RDNA 架构迭代路径清晰,RDNA3 架构采用 5nm 工艺和 chiplet 设计,比 RDNA 2 架构有 54%每瓦性能提升,预计 2024 年前 RDNA 4 架构可正式发布,将采用更为先进的工艺制造。

目前国内厂商在图形渲染 GPU 方面与国外龙头厂商差距不断缩小。芯动科技的“风华 2 号”GPU 像素填充率 48GPixel/s,FP32 单精度浮点性能 1.5TFLOPS,AI 运算(INT8)性能 12.5TOPS,实测功耗 4~15W,支持 OpenGL4.3、DX11、Vulkan 等 API,实现国产图形渲染 GPU 突破。景嘉微在工艺制程、核心频率、浮点性能等方面虽落后于英伟达同代产品,但差距正逐渐缩小。2023 年顺利发布 JM9 系列图形处理芯片,支持 OpenGL 4.0、HDMI 2.0 等接口,以及 H.265/4K 60-fps 视频解码,核心频率至少为 1.5GHz,配备 8GB显存,浮点性能约 1.5TFlops,与英伟达 GeForce GTX1050 性能相近,有望对标 GeForce GTX1080。

GPGPU:英伟达和 AMD 是目前全球 GPGPU 的领军企业。英伟达的通用计算芯片具备优秀的硬件设计,通过 CUDA 架构等全栈式软件布局,实现了 GPU 并行计算的通用化,深度挖掘芯片硬件的性能极限,在各类下游应用领域中,均推出了高性能的软硬件组合,逐步成为全球 AI 芯片领域的主导者。根据 stateof.AI 2022 报告,英伟达芯片在 AI 学术论文中的出现频次远超其他类型的 AI 芯片,是学术界最常用的人工智能加速芯片。

在 Oracle 以及腾讯云中,也几乎全部采用英伟达的 GPU 作为计算加速芯片。AMD 2018 年发布用于数据中心的Radeon Instinct GPU 加速芯片,Instinct 系列基于 CDNA 架构,如 MI250X 采用 CDNA2 架构,在通用计算领域实现计算能力和互联能力的显著提升,此外还推出了对标英伟达 CUDA 生态的 AMD ROCm 开源软件开发平台。英伟达的 H100 及 A100、AMD 的 MI100、MI200 系列等是当前最为主流的 GPGPU 产品型号。

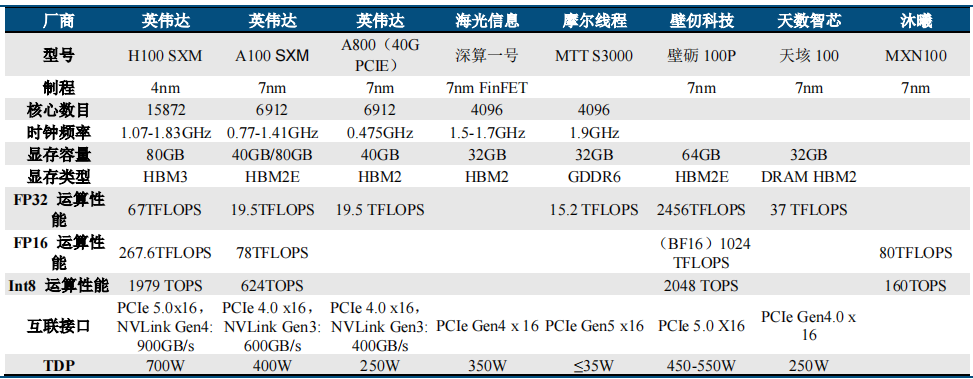

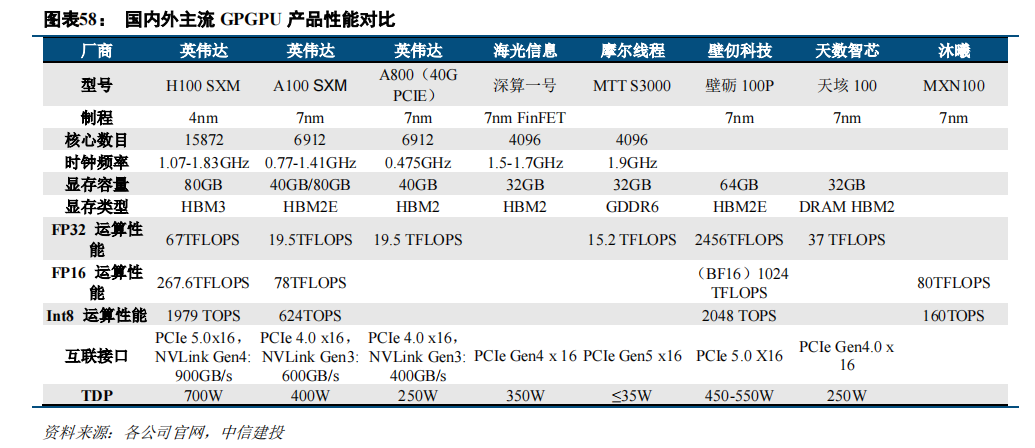

国内 GPGPU 厂商正逐步缩小与英伟达、AMD 的差距。英伟达凭借其硬件产品性能的先进性和生态构建的完善性处于市场领导地位,国内厂商虽然在硬件产品性能和产业链生态架构方面与前者有所差距,但正在逐步完善产品布局和生态构建,不断缩小与行业龙头厂商的差距。国内主要 GPGPU 厂商及产品如下:

1)海光信息:公司第一代 DCU 产品深算一号已于 2021 年实现商业化应用,采用 7nm 制程,基于大规模并行计算微结构进行设计,能支持 FP64 双精度浮点运算,同时在单精度、半精度、整型计算方面表现同样优异,是一款计算性能强大、能效比较高的通用协处理器,且该产品集成片上高带宽内存芯片,可以在大规模数据计算过程中提供优异的数据处理能力,高速并行数据处理能力强大,在典型应用场景下,主要性能指标可对标 AMDMI100、英伟达 P100,接近英伟达 A100;第二代 DCU 产品深算二号处于研发阶段,进展顺利。DCU 系列产品全面兼容“类 CUDA”环境,因此能够较好地适配、适应国际主流商业计算软件和人工智能软件,公司积极参与开源软件项目,加快了公司产品的推广速度,并实现与 GPGPU 主流开发平台的兼容。未来有望广泛应用于大数据处理、人工智能、商业计算等领域。

2)天数智芯:2021 年 11 月宣布量产国内首款云端 7nm GPGPU 产品卡“天垓 100”,采用业界领先的台积电 7nm FinFET 制造工艺、2.5D CoWoS 封装技术,搭配台积电 65nm 工艺的自研 Interposer(中介层),集成多达240 亿个晶体管,整合 32GB HBM2 内存、存储带宽达 1.2TB,支持 FP32、FP/BF16、INT32/16/8 等多精度数据混合训练,系统接口 PCIe 4.0 x16。支持国内外主流 GPGPU 生态和多种主流深度学习框架。

3)壁仞科技:2022 年 9 月针对人工智能训练、推理,及科学计算等更广泛的通用计算场景推出 BR100 系列通用 GPU 芯片,目前主要包括 BR100、BR104 两款芯片,基于壁仞科技原创芯片架构研发,采用 7nm 制程,可容纳 770 亿颗晶体管,并在国内率先采用 Chiplet 技术,新一代主机接口 PCIe 5.0,支持 CXL 互连协议,双向带宽最高达 128GB/s,具有高算力、高通用性、高能效三大优势。创下全球算力纪录,16 位浮点算力达到 1000T以上、8 位定点算力达到 2000T 以上,单芯片峰值算力达到 PFLOPS 级别,达到国际厂商在售旗舰产品 3 倍以上,创下国内互连带宽纪录。

4)摩尔线程:2022 年基于自研第二代 MUSA 架构处理器“春晓”GPU 推出针对数据中心的全功能 MTT S2000/S3000。MTT S3000 具有 PCIe Gen5 接口,FP32 算力为 15.2 TFLOPS,核心频率 1.9 GHz,显存容量 32 GB,支持 MUSA 安全引擎 1.0 以及 GPU 弹性切分技术,支持在云端的虚拟化和容器化。此外,摩尔线程推出了完备的 MUSA 软件栈,可帮助 MUSA 开发者快速基于摩尔线程全功能 GPU 开发各种不同的应用软件,并可通过CUDA ON MUSA 兼容 CUDA 语言开发。

5)沐曦:沐曦首款异构 GPGPU 产品 MXN100 采用 7nm 制程, 已于 2022 年 8 月回片点亮, 主要应用于推理侧;应用于 AI 训练及通用计算的产品 MXC500 已于 2022 年 12 月交付流片,公司计划 2024 年全面量产。2023 年发布首款 AI 推理 GPU 加速卡——曦思 N100 及解决方案在安防领域的应用。曦思 N100 是一款面向云端数据中心应用的 AI 推理 GPU 加速卡,内置异构的 GPGPU 通用处理器核心“MXN100”,同时集成了HBM2E 高带宽内存,单卡的 INT8 整数算力达 160TOPS,FP16 浮点算力则达 80TFLOPS,具备高带宽、低延时特性。支持 128 路编码和 96 路解码的高清视频处理能力,兼容 HEVC(H.265)、H.264、AV1、AVS2 等多种视频格式,最高支持 8K 分辨率。

ASIC 市场方面,由于其一定的定制化属性,市场格局较为分散。在人工智能领域,ASIC 也占据一席之地。

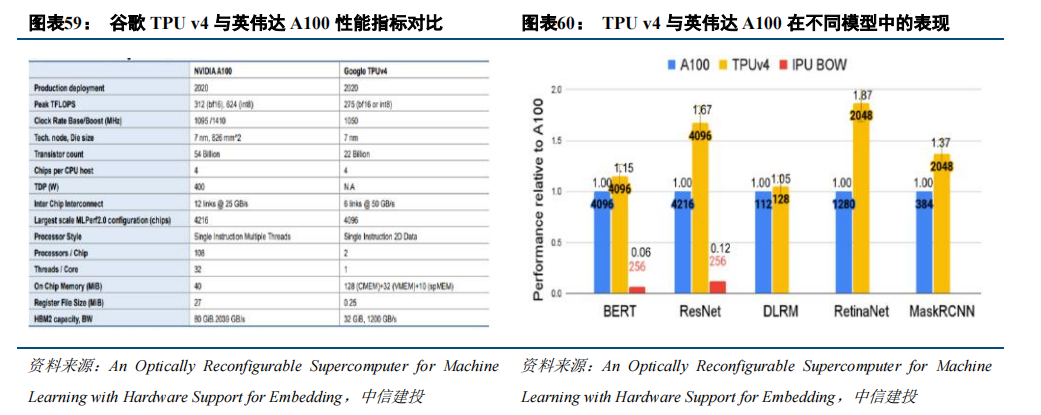

其中谷歌处于相对前沿的技术地位,自 2016 年以来,就推出了专为机器学习定制的 ASIC,即张量处理器(Tensor Processing Unit,TPU),近期,谷歌首次公布了其用于训练人工智能模型的 AI 芯片 TPU v4 的详细信息,其采用低精度计算,在几乎不影响深度学习处理效果的前提下大幅降低了功耗、加快运算速度,同时使用了脉动阵列等设计来优化矩阵乘法与卷积运算,对大规模矩阵的乘法可以最大化数据复用,减少访存次数,大幅提升Transformer 模型的训练速度,同时节约训练成本。

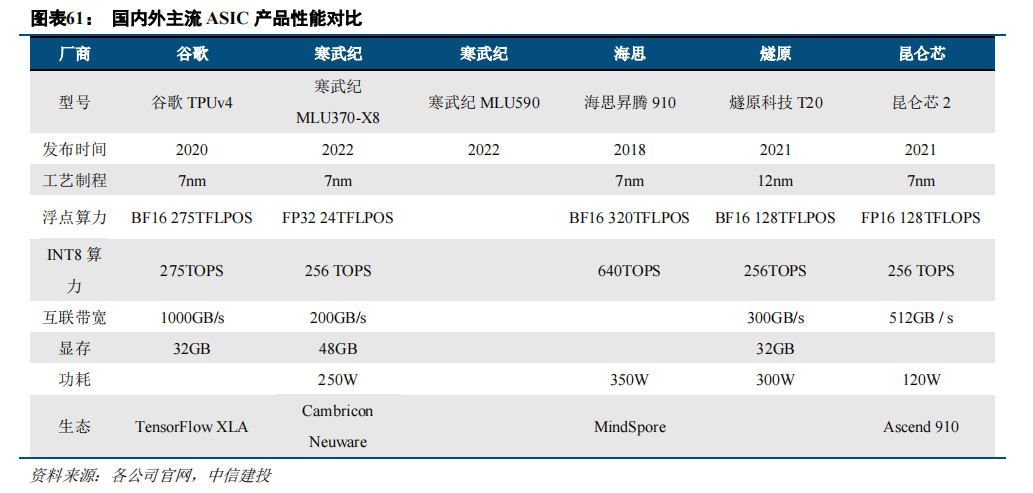

国产厂商快速发展,寒武纪等异军突起。通过产品对比发现,目前寒武纪、海思昇腾、遂原科技等国产厂商正通过技术创新和设计优化,持续提升产品的性能、能效和易用性,推动产品竞争力不断提升,未来国产厂商有望在 ASIC 领域持续发力,突破国外厂商在 AI 芯片的垄断格局。国内主要 AI 用 ASIC 厂商及产品如下:

1)寒武纪:云端人工智能领域,推出思元系列产品。其中,MLU100 芯片是中国首款高峰值云端智能芯片。MLU290 芯片是寒武纪首款云端训练智能芯片,采用了 7nm 工艺,性能功耗上接近英伟达 A100,理论峰值性分别高达 1024TOPS(INT4)、512TOPS(INT8)。思元 370(MLU370)芯片是寒武纪首款采用 Chiplet(芯粒)技术的人工智能芯片,是寒武纪第二代云端推理产品思元 270 算力的 2 倍。MLU370-X8 与 MLU370-M8 是寒武纪基于思元 370 云端智能芯片打造的两款不同形态的人工智能加速卡。MLU370-X8 采用双芯思元 370 配置,为双槽位 250w 全尺寸智能加速卡,提供 24TFLOPS(FP32)训练算力和 256TOPS(INT8)推理算力;MLU370-M8 是寒武纪面向数据中心场景打造的 OAM 形态智能加速卡,可提供 32TFLOPS(FP32)训练算力和 340 TOPS(INT8)推理算力。两款加速卡均支持寒武纪 MLU-Link 芯片间互联,可满足多样化人工智能模型的训练和推理需求。

此外,公司正在开展新一代思元 590 的开发,将采用 MLUarch05 全新架构,能够提供更大的内存容量和更高的内存带宽,其 I/O 和片间互联接口也较上代实现大幅升级。

2)华为海思:推出昇腾系列产品。其中昇腾 310 在典型配置下可以输出 16TOPS@INT8, 8TOPS@FP16,功耗仅为 8W,采用自研华为达芬奇架构,集成丰富的计算单元, 提高 AI 计算完备度和效率,进而扩展该芯片的适用性,全 AI 业务流程加速,大幅提高 AI 全系统的性能,有效降低部署成本。昇腾 910 是业界算力最强的AI 处理器,基于自研华为达芬奇架构 3D Cube 技术,半精度(FP16)算力达到 320 TFLOPS,整数精度(INT8)算力达到 640 TOPS,功耗 310W,可支持云边端全栈全场景应用。表观性能上,昇腾 910 芯片性能接近英伟达A100,但华为是基于自研的深度学习框架 MindSpore 与算力芯片进行相互优化,与 Tensorflow/Pytorch 两大主流深度学习训练框架的融合度不足,未来仍需要一定的时间进行生态建设。

3)燧原科技:2019 年 12 月首发云端 AI 训练加速芯片邃思 1.0 及训练加速卡产品,2020 年推出推理加速卡,2021 年 7 月推出的第二代云端 AI 训练加速芯片邃思 2.0,单精度 FP32 峰值算力达到 40TFLOPS,单精度张量 TF32 峰值算力达到 160TFLOPS。同时搭载了 4 颗 HBM2E 片上存储芯片,高配支持 64GB 内存,带宽达1.8TB/s。

4)昆仑芯:昆仑芯 1 代 AI 芯片于 2020 年量产,在百度搜索引擎、小度等业务中部署数万片,是国内唯一一款经历过互联网大规模核心算法考验的云端 AI 芯片。昆仑芯 2 代 AI 芯片于 2021 年 8 月量产,是国内首款采用 GDDR6 显存的通用 AI 芯片,相比昆仑芯 1 代 AI 芯片性能提升 2-3 倍,且在通用性、易用性方面也有显著增强。昆仑芯 3 代有望在 2024 年规模上市,或将采用了 Huawei Da Vinci(达芬奇) 架构,峰值性能为 256TeraFLOPS,支持更多的运算和深度学习技术,例如 ONNX、TensorFlow 和 PyTorch。

英伟达领先地位稳固。英伟达凭借良好的硬件性能和完善的 CUDA 生态将持续处于领先地位,但起步较晚的挑战者也在奋起直追,未来有望出现一超多强的多元化竞争格局。训练市场方面,英伟达高算力 GPU 是当前AI 训练主流选择,谷歌 TPU 面临着通用性的局限,AMD 存在生态构建差距,但在二者的冲击及云厂商自研芯片的竞争下,AI 训练市场也或将出现格局的变动。推理市场方面,GPU 具有较好的生态延续性仍占主流,如英伟达针对推理市场的产品 Tesla T4 上的芯片包含了 2560 个 CUDA 内核,性能达到了 FP64 0.25 TFLOPS、FP32 8.1TFLOPS、INT8 达 130 TOPS,可提供多精度推理性能,以及优于 CPU 40 倍的低延时高吞吐量,可以实时满足更多的请求。但其他解决方案在成本、功耗具有优势,特定市场竞争格局相对激烈,工作负载不同对应的芯片性能需求不同,T4 PCIe,有望出现各类芯片共存的局面。

国内算力芯片厂商具备较好的入局机会。国产算力芯片市场需求巨大,国内人工智能生态环境较好,在 AI应用领域的步伐处于全球前列,国产 GPU 厂商具孵化和发展的沃土,国内厂商供应链多元化的需求带来了国内AI 芯片厂商适配窗口期,尤其是当前大模型发展早期是适配的黄金窗口期。其中,寒武纪、华为等兼容 CUDA和自建生态是国产厂商发展的两大趋势,具备很大的竞争力潜力。短期来看,国内厂商兼容英伟达 CUDA,可以减轻开发和迁移难度,进而快速实现客户端导入。

同时需要避开英伟达绝对优势领域,在芯片设计结构上形成差异化竞争;长期来看,国产 GPU 如果完全依赖 CUDA 生态,硬件更新将不得不绑定英伟达的开发进程,应借鉴 AMD、Google 构建自身生态体系,开展软硬件结合的平台化布局,并打造不同领域快速落地垂直解决方案的能力,铸造自己的生态圈核心壁垒。预计硬件性能高效以及能够构建符合下游需求的生态体系的国产厂商有望脱颖而出。